Desde tiempos antiguos, el ser humano ha sentido la necesidad de dotar de vida lo inerte. Esta fascinación no surgió con la computación, sino con los relatos que cruzaban generaciones mucho antes del papel o la electricidad. En la antigua Grecia, por ejemplo, se hablaba de Hefesto, dios del fuego, quien habría creado autómatas de oro para que lo asistieran. En la tradición judía, el Golem —una figura de barro animada por conjuros— respondía a las órdenes de quien lo creaba.

Estas historias no solo alimentaban la imaginación, sino que daban forma a un deseo profundo: crear algo que nos comprendiera, que obedeciera, o incluso que se nos asemejara. El mito no era simplemente una alegoría, sino una representación simbólica del primer concepto de inteligencia artificial: una mente no humana, capaz de operar con cierta autonomía.

Así, sin que existiera aún la palabra “algoritmo”, ya se habían sembrado las semillas de lo que siglos después llamaríamos IA. La idea no era técnica, sino cultural: imaginar entidades pensantes fuera del cuerpo humano fue el verdadero comienzo de esta historia.

ELIZA y el nacimiento de una mente simulada

En 1966, en los laboratorios del MIT, Joseph Weizenbaum presentó al mundo un programa llamado ELIZA. A simple vista, parecía un juego de preguntas y respuestas, pero para muchos, fue algo revolucionario: una máquina que podía “conversar”. ELIZA simulaba el papel de una psicoterapeuta, devolviendo preguntas al usuario en función de lo que este escribía. No entendía, no analizaba, pero sabía cómo mantener una ilusión de diálogo.

La sorpresa fue que muchas personas reaccionaban emocionalmente al programa. Le atribuían comprensión, empatía e incluso inteligencia. Weizenbaum, desconcertado por este fenómeno, llegó a cuestionar el papel de la tecnología en la relación humana. Había creado algo que no pensaba por sí mismo, pero que engañaba al interlocutor con notable eficacia.

Así, ELIZA se convirtió en la primera IA reconocida culturalmente como tal. No por su capacidad técnica, sino por lo que provocaba en quienes interactuaban con ella. Fue la prueba de que la inteligencia artificial no necesita ser perfecta para ser percibida como real.

El conocimiento embotellado en líneas de código

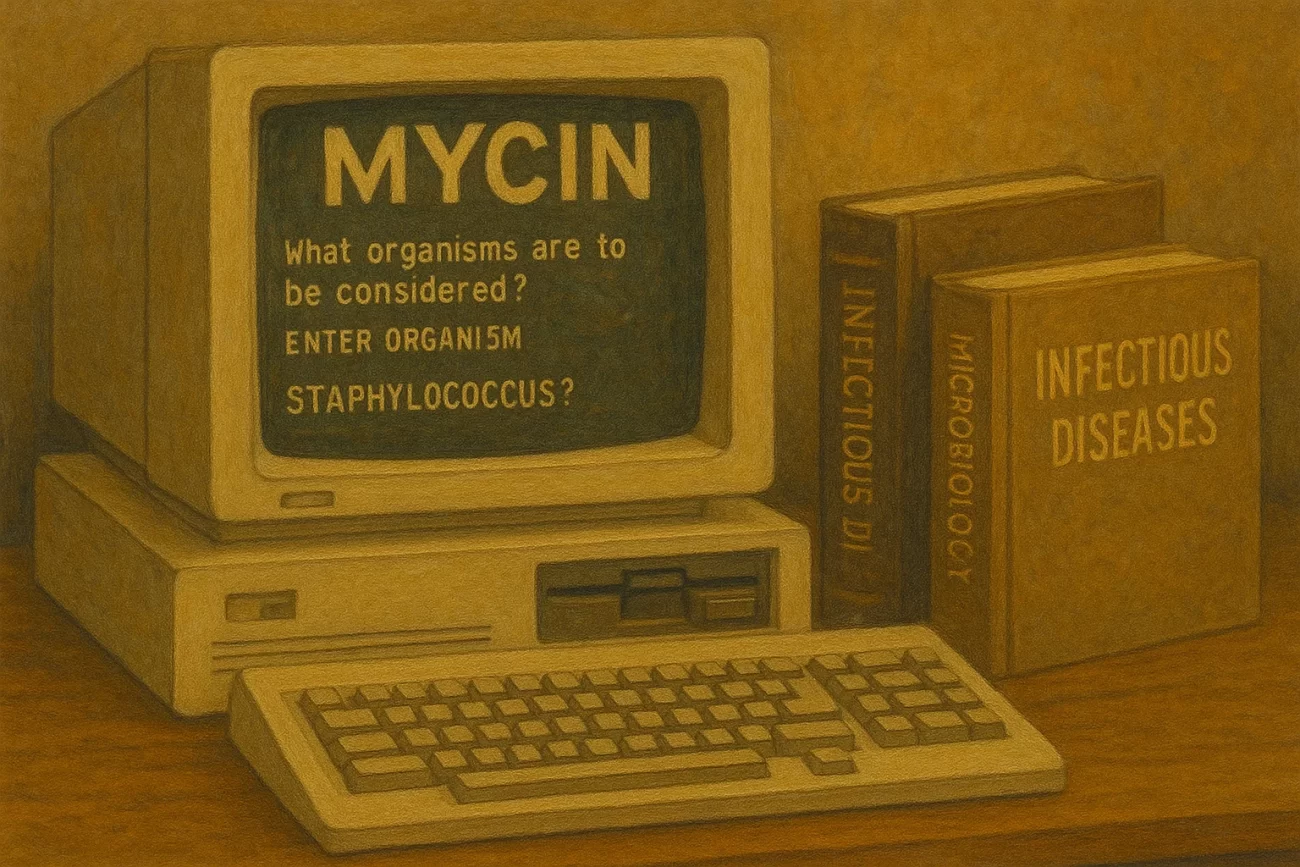

A medida que avanzaba la informática, surgieron los sistemas expertos. Estos programas no hablaban como ELIZA, pero sabían cosas. DENDRAL, creado para ayudar en tareas de química, y MYCIN, enfocado en diagnósticos médicos, fueron algunos de los primeros ejemplos. Su lógica se basaba en reglas: si A y B ocurren, entonces C es la solución. No aprendían, pero eran precisos dentro de su dominio.

Lo interesante de estos sistemas no era solo su capacidad para ofrecer respuestas, sino el modo en que representaban el conocimiento humano. Médicos y científicos colaboraban con ingenieros para volcar su experiencia en forma de decisiones automatizadas. En cierto sentido, se embotellaba la sabiduría de los expertos.

Este tipo de IA marcó una transición importante. Ya no se trataba de simular una conversación, sino de construir una mente especializada. El ideal no era una máquina “inteligente en general”, sino capaz de hacer bien tareas concretas. Un paso clave hacia la funcionalidad real.

De lo estático a lo adaptable

La década de los 80 trajo consigo un giro radical: el aprendizaje automático. A diferencia de los sistemas anteriores, estas nuevas IAs no necesitaban que un humano les indicara todas las reglas. Bastaba con que procesaran grandes cantidades de datos para descubrir patrones por sí mismas. Aprendían, mejoraban, y se adaptaban.

Este cambio tuvo implicaciones profundas. Por ejemplo, en vez de programar todos los criterios para reconocer un rostro, se podían alimentar miles de imágenes a una IA para que identificara por su cuenta qué rasgos eran relevantes. El conocimiento ya no se transmitía por reglas, sino por experiencia.

Así nació una nueva etapa en la inteligencia artificial, donde la lógica dio paso a la estadística, y los programadores se convirtieron en entrenadores. El foco ya no era emular el pensamiento humano, sino construir algo útil, aunque funcionara de un modo completamente distinto al nuestro.

Invisible, útil y cada vez más cercana

Hoy, la inteligencia artificial habita en los rincones más cotidianos de nuestra vida. Desde los filtros de redes sociales hasta los motores de recomendación, pasando por asistentes de voz, sistemas de navegación o algoritmos de traducción, la IA está presente, aunque pocas veces la notemos.

Modelos como ChatGPT, por ejemplo, han cruzado un umbral significativo. Ya no se limitan a responder con reglas o patrones básicos: generan texto, resumen ideas, resuelven problemas y, en muchos casos, parecen entendernos. Aunque no piensen como nosotros, funcionan lo bastante bien como para formar parte de nuestras rutinas.

Lo paradójico es que, mientras más útil y precisa se vuelve una IA, menos “mágica” parece. Se vuelve invisible, como ocurre con toda tecnología madura. Y es entonces cuando su impacto se vuelve más profundo: cuando deja de ser novedad y empieza a ser hábito.

Un espejo que nos obliga a redefinirnos

Pensar en los inicios de la inteligencia artificial es también reflexionar sobre nosotros mismos. La IA, en todas sus formas, no ha hecho más que seguir nuestras preguntas fundamentales: ¿Qué es pensar? ¿Qué nos hace humanos? ¿Puede algo distinto a nosotros aprender, decidir o comprender?

Desde los mitos antiguos hasta los algoritmos modernos, la constante ha sido el deseo de proyectarnos en otra forma. La IA es una herramienta, sí, pero también un reflejo. Al construirla, descubrimos límites, miedos y posibilidades que no sabíamos que teníamos.

Quizás la verdadera inteligencia no esté en las máquinas, sino en la forma en que decidimos usarlas. Porque más allá de lo que una IA pueda decir o hacer, siempre quedará en nuestras manos la pregunta más difícil de todas:

¿Para qué queremos que piensen las máquinas?